L’intelligence artificielle : alliée ou menace ?

Devenue discipline académique dès 1956, l'IA est récemment présente de plus en plus dans notre vie quotidienne, et ses bénéfices ne se laissent pas attendre.

Corina Cristea, 22.03.2024, 14:23

L’IA, avec nous depuis 1956

Définie comme un ensemble des théories et des techniques développant des programmes informatiques complexes capables de simuler certains traits de l’intelligence humaine pour assumer certaines charges concrètes et flexibles, l’IA emploie des algorithmes qui utilisent de grands volumes de données et des techniques de pointe qui font appel à l’apprentissage automatique, à l’analyse de langage, à des techniques informatiques.

Des bénéfices multiples

Devenue discipline académique dès 1956, l’IA est récemment présente de plus en plus dans notre vie quotidienne, et ses bénéfices ne se laissent pas attendre.

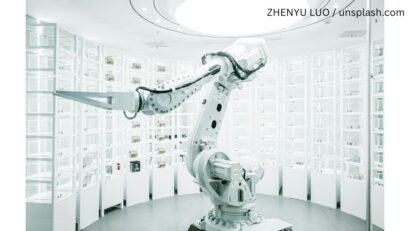

Qu’il s’agisse de son utilisation pour améliorer les process d’usinage, pour augmenter la qualité de l’assistance médicale, pour améliorer la sécurité et l’économie en matière des transports, l’IA peut aussi faciliter l’apparition de nouveaux produits ou encore augmenter la sécurité au travail, lorsque les robots reprennent la réalisation des taches pénibles et dangereuses. Mais l’utilisation à grande échelle de l’IA n’est pas exempte de risques pour la sécurité des hommes et des entreprises, pour la démocratie, tout comme pour la sécurité des emplois. Les technologies de contrefaçons profondes risquent de fausser par exemple les processus électoraux et démocratique.

Comment les programmes de contrefaçon profondes peuvent nuire à la démocratie

Flavia Durach, universitaire spécialisée dans l’étude des techniques de désinformation, explique la manière dont ces programmes de contrefaçons profondes peuvent nuire à la démocratie :

« Ils vont tout d’abord exacerber la composante émotionnelle au sein de l’électorat, ce qui risquent de faire pencher la balance au profit d’un certain candidat ou formation politique. La manipulation émotionnelle détient un rôle essentiel au sein du mécanisme de désinformation, pouvant mener à des décisions irrationnelles, qui font fi de la pensée critique, induire des sentiments forts, telle la peur ou la révolte, qui prennent le dessus sur le rationnel. Prenez l’utilisation des technologies de contrefaçons profondes lors des élections, dans la tentative de compromettre un certain candidat par exemple. Ce genre de situation instille le doute dans le chef de l’électorat, surtout au sein de l’électorat indécis, d’autant que les produits issus de contrefaçons profondes sont distribués à grande échelle, touchant le public large. »

Un accord pour lutter contre les tentatives de désinformation en cette année électorale

Pour tenter d’enrayer ce genre de pratiques, un consortium de 20 sociétés du secteur des nouvelles technologies, dont de grands noms de l’IA, telles OpenIA, Microsoft et Meta, ont récemment signé un accord qui les engage à combattre les tentatives de désinformation qui pourront survenir en cette année électorale. Conclu à l’issue de la conférence sur la sécurité de Munich, l’accord a été également signé parles détenteurs des plus importants réseaux sociaux, dont Meta, TikTok et X (ex Twitter), qui se sont à leur tour engagés d’éliminer les contenus toxiques et les infox de leurs plateformes. Et c’est toujours grâce à l’IA que seront identifiés pour être ensuite éliminés les vidéos, les images, les contenus suspects. Par ailleurs, la grande majorité des créateurs de contenu réalisé grâce à l’IA ont agréé d’utiliser le filigrane comme moyen censé faire la distinction entre le contenu réalisé grâce à l’IA et le contenu réel.

C’est un bon début, selon Flavia Durach :

« Il faut néanmoins prendre en considération l’expérience antérieure, notamment ce qui s’est passé lors de la pandémie du Covid-19, lorsqu’avaient émergé de telles promesses d’étiqueter les contenus réalisés au moyen de l’IA, ce qui n’a pas empêché à ce que des études et des chercheurs indépendants retrouvent un grand nombre d’enfreintes à la règle. Ce qui signifie qu’une bonne partie des infox, de ce contenu toxique passe à travers les mailles du filet. Je demeure donc plutôt sceptique quant à l’efficacité de ces chiens de garde à la lumière des expériences antérieures ».

« En l’absence des mesures législatives, des règlementations établies aux niveaux national et international qui fassent développer l’IA sur des bases éthiques, et en minimisant les risques associés, rien de bon ne sortira de cette affaire », avait conclu Flavia Durach, universitaire spécialisée dans l’étude des techniques de désinformation.

UE : une loi sur l’IA

Des pas importants ont été réalisés en ce sens au niveau de l’UE, dont la nouvelle loi sur l’IA récemment adoptée par le Parlement européen, et qui oblige les producteurs de contenu de clairement marquer les productions réalisées par l’IA. La loi ne deviendra d’application que de manière progressive, dans les deux années qui suivent son entrée en vigueur. (Trad Ionut Jugureanu)